【深度学习】面向医学图像的病灶分割调研(三)

【深度学习】面向医学图像的病灶分割调研(三)

文章目录

任务1

任务2

任务3

基于剪枝Swin-Unet进行医学图像病灶分割

总结

参考任务1

理解深度学习在医学图像中的应用并总结:

在过去的几十年里,计算机断层扫描(CT)、磁共振成像(MRI)、正电子发射断层扫描术(PET)、乳房X光检查、超声波、X射线等医学成像技术,已被广泛用于疾病的早期发现、诊断和治疗。在临床上,医学图像的解释大多是由放射科医生和内科医生等人类专家进行的。然而,考虑到病理上的巨大差异和人类专家的潜在疲劳,研究人员和医生已经开始从计算机辅助干预中受益。虽然计算医学图像分析的发展速度没有医学成像技术那么快,但随着机器学习技术的引入,这种情况正在改善。在机器学习应用的过程中,发现或学习能够很好地描述数据固有规律或模式的有效特征,在医学图像分析的各种任务中起着至关重要的作用。传统上,有意义的或与任务相关的特征通常主要是由人类专家根据他们对目标领域的知识设计的,这使得非专家在自己的研究中利用机器学习技术具有挑战性。与此同时,努力学习基于预定义字典的稀疏表示,而这是可能会从训练样本中学习到的。在许多科学领域中,稀疏表示的动机是简约原则,即对给定观测的最简单解释应该优先于更复杂的解释。然而,深度学习通过将特征工程步骤合并到学习步骤中,克服了这个障碍。也就是说,深度学习只需要经过较小预处理的一组数据,然后以自学方式发现信息表示,而不是手动提取特征。因此,特征工程的负担已经从人类转移到了计算机上,使得机器学习中的非专家可以有效地将深度学习用于他们自己的研究和应用,特别是在医学图像分析中。此外,深度学习应用在医学图像分割上,追求的往往是优雅的端对端框架。

深度学习在医学图像领域的一些限制:

缺少高质量的标注的训练样本,因此训练出来的模型可能是过拟合的或者说推广性不好,因此需要将的到的模型放在各种情况下测试推广性。

深度学习得到的模型是一个黑盒子,无法解释其有效性,在一些特殊的情况下会出现非常奇怪无法解释的问题,因此在医疗行业中的接受度也是一个问题。

任务2

在医学成像的过程中图像会不可避免地会受到噪声、伪影等各种因素的影响。有哪些预处理方法或图像处理方法能获得相对干净的训练样本?

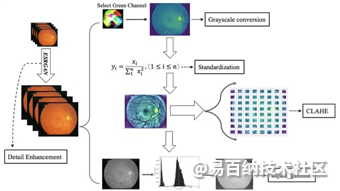

在眼底血管图像的分割任务中,我使用的图像预处理方法如图5-1所示,该处理流程应用在眼底血管图像分割上获得了很好的效果。

图5-1 图像预处理流程

(1)细节增强。DRIVE和STARE两个数据库的眼底图像都为RGB图像,每个像素颜色由红、绿、蓝三色的混合值组成。为提高分割准确率,本文首先使用ESRGAN网络处理每个数据集的20张图像。处理之后眼底图像对比度增高,血管轮廓与背景差距增大,噪声也变小,有利于后续血管分割。

(2)灰度转换。将原彩色的眼底图像转换为红色(R)、绿色(G)和蓝色(B)3个通道的图像,使用噪声更小的通道图像。

(3)标准化。对G通道的眼底图像的均值和标准差进行归一标准化,再对正向序列x1,x2,…,xn进行变换:

通过该操作消除了眼底图像数据特征间单位和尺度差异的影响。

(4)对比度受限的自适应直方图均衡化(CLAHE)。该算法用于增强图像数据对比度,眼底图像被切分为8行8列的64小块,对每个图像块使用直方图均衡化处理,CLAHE使用预定义的阈值来裁剪直方图以达到预处理目的,去除图像噪音,提升图像质量。

(5)伽马变换。用于调整输入眼底图像光照的强度,对输入图像灰度值进行的非线性操作,使输入图像灰度值与输出图像灰度值呈指数关系:

这种处理提升了眼底图像暗部细节,通过非线性变换,让眼底图像从暴光强度的线性响应变得更接近人眼感受的响应,即将漂白或过暗的图片,进行矫正。

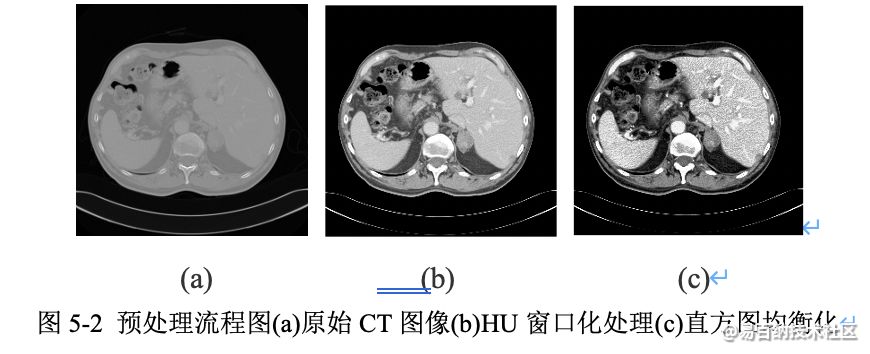

在肝脏CT自动分割任务中,我使用的图像预处理方法如图5-2所示。在预处理阶段,为了去除不相关的QG和细节,将图像Hounsfield强度统一在[-200,200]之间,并应用直方图均衡化,来增强图像的对比度和清晰度。然后,将所有数据的z轴的间距设置为1mm,将图片的强度范围归一化到[0,1]。最后,为了进一步优化训练时的模型权重,对所有图片像素值做了标准化处理,预处理流程如图3所示。

任务3

近几年基于深度学习的病灶/肿瘤分割的趋势是什么(比如,针对医学数据集规模小、数据标注难的问题,许多研究使用弱监督学习方法)?

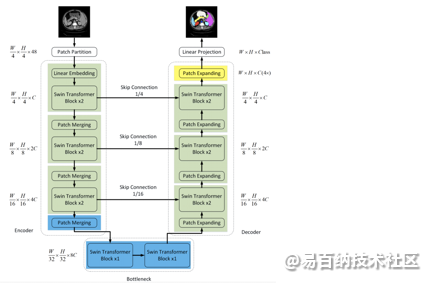

在网络模型方面,过去的几年中,卷积神经网络(CNN)在医学图像分析中取得了里程碑式的进展。尤其是,基于U形结构和skip-connections的深度神经网络已广泛应用于各种医学图像任务中。在医学图像病灶/肿瘤分割领域,各种U-Net的改进网络不断出现,也取得了理想的效果。但是,尽管CNN取得了出色的性能,但是由于卷积操作的局限性,它无法很好地学习全局和远程语义信息交互。最近,首个基于纯Transformer的U-Net形的医学图像分割网络,其中利用Swin Transformer构建Encoder、Bottleneck和Decoder,表现更优,性能优于TransUnet、Att-UNet等。它是用于医学图像分割的类似U-net的纯Transformer模型。标记化的图像块通过跳跃连接被送到基于Transformer的U形Encoder-Decoder架构中,以进行局部和全局语义特征学习。网络结构如图6-1所示。

图6-1 Swin-Unet网络结构

在数据增强和训练方法层次,由于医学图像标签获取费时费力,且成本极高,半监督和弱监督学习势必成为图像语义分割中深度学习方法的主流。这篇论文[12]提出了一种基于深度神经网络的弱监督语义分割算法,该算法仅依赖于图像级类标签。所提出的算法在生成分割注释和使用生成的注释学习语义分割网络之间交替。该框架成功的关键决定因素是仅在给定图像级标签的情况下构建可靠初始注释的能力。为此,论文提出了超像素池化网络(SPN),它利用输入图像的超像素分割作为汇集布局,以反映用于学习和推断语义分割的低级图像结构。然后,使用由SPN生成的初始注释来学习估计像素方式语义标签的另一神经网络。分段的体系结构网络将语义分割任务分解为分类和分割,以便网络在嘈杂的注释之前学习类别不可知的形状。事实证明,两个网络对于提高语义分割准确性至关重要。

此外,我认为使用GAN网络生成大量的医学图像样本也是一个解决医学图像标注数据量少的好方法。在训练方法层次上,我认为孪生网络和知识蒸馏也能很好解决小样本训练问题。

基于剪枝Swin-Unet进行医学图像病灶分割

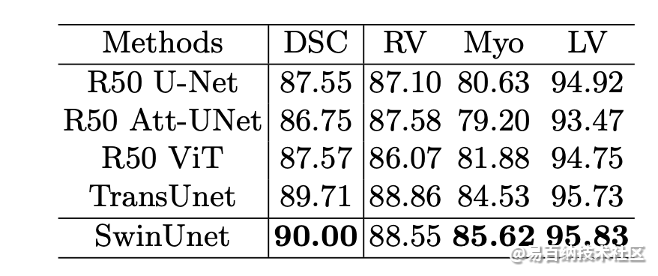

Swin-Unet[13],它是用于医学图像分割的类似U-Net的纯Transformer模型。标记化的图像块通过跳跃连接被送到基于Transformer的U形Encoder-Decoder架构中,以进行局部和全局语义特征学习。其在医学图像分割上的性能已经得到了很好的验证,如表7-1所示。

表7-1 不同方法在ACDC数据集上的分割精度。

我认为该模型存在两个改进方向。第一,网络的参数量过大,轻量级的网络往往更能胜任临床的任务,可以通过网络剪枝解决,目前网络剪枝还没有准确的规范,是一个很好的研究思路;第二,将其应用在病灶区域的分割上,网络整体训练为端对端的三分类框架,可以同时分割出QG和肿瘤区域。

总结

在肝癌的诊断和手术规划中,肝脏分割是必不可少的一个关键前提。传统上,放射科医生获取病人CT图像之后,需要手动对每个切片逐一人工标注,以获取肝脏区域和肿瘤区域。然而,这个过程非常耗时,且易受医生主观意识的影响。

基于经典U-Net的方法在医学图像分类问题非常成功,但是仍然存在的一些不足。首先,U-Net卷积单元后的特征图,缺少特征信息的二次提炼过程;其次,类别不平衡问题,易导致模型分割过程中,遗漏掉小肝脏区域、肝脏不连续区域以及肝脏肿瘤边界模糊的区域;再者,U-Net网络逐步下采样的过程会降低图像的分辨率,从而导致分割精度的下降;最后,伴随网络深度的加深,很容易诱发梯度消失问题。

参考

[1]. Seo H, Huang C, Bassenne M, et al. Modified U-Net (mU-Net) with incorporation of object-dependent high level features for improved liver and liver-tumor segmentation in CT images[J]. IEEE transactions on medical imaging, 2019, 39(5): 1316-1325.

[2]. Isensee F, Maier-Hein K H. nnU-Net for Brain Tumor Segmentation[C]//Brainlesion: Glioma, Multiple Sclerosis, Stroke and Traumatic Brain Injuries: 6th International Workshop, BrainLes 2020, Held in Conjunction with MICCAI 2020, Lima, Peru, October 4, 2020, Revised Selected Papers, Part II. Springer Nature, 2021, 12658: 118.

[3]. Isensee F, Maier-Hein K H. An attempt at beating the 3D U-Net[J]. arXiv preprint arXiv:1908.02182, 2019.

[4]. Wang W, Chen C, Ding M, et al. TransBTS: Multimodal Brain Tumor Segmentation Using Transformer[J]. arXiv preprint arXiv:2103.04430, 2021.

[5]. Haralick RM, Shapiro LG. Computer and Robot Vision[M]. Addison-Wesley. 1992:100-110.

[6]. REN S, GIRSHICK R, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans Pattern Anal Mach Intell, 2017, 39(6): 1137-1149.

[7]. REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//International Conference on Neural Information Processing Systems. Cambridge, Massachusetts: MIT Press, 2015: 91-99.

[8]. P. Kickingereder, F. Isensee, I. Tursunova, J. Petersen, U. Neuberger, D. Bonekamp, G. Brugnara, M. Schell, T. Kessler, M. Foltyn et al., “Automated quantitative tumour response assessment of mri in neuro-oncology with artificial neural networks: a multicentre, retrospective study,” The Lancet Oncology, vol. 20, no. 5, pp. 728–740, 2019.

[9]. P. Kickingereder, U. Neuberger, D. Bonekamp, P. L. Piechotta, M. Go ̈tz, A. Wick, M. Sill, A. Kratz, R. T. Shinohara, D. T. Jones et al., “Radiomic subtyping im- proves disease stratification beyond key molecular, clinical, and standard imaging characteristics in patients with glioblastoma,” Neuro-oncology, vol. 20, no. 6, pp. 848–857, 2018.

[10]. P. Kickingereder, M. Go ̈tz, J. Muschelli, A. Wick, U. Neuberger, R. T. Shinohara, M. Sill, M. Nowosielski, H.-P. Schlemmer, A. Radbruch et al., “Large-scale radiomic profiling of recurrent glioblastoma identifies an imaging predictor for stratifying anti-angiogenic treatment response,” Clinical Cancer Research, vol. 22, no. 23, pp. 5765–5771, 2016.

[11]. Chen J, Lu Y, Yu Q, et al. Transunet: Transformers make strong encoders for medical image segmentation[J]. arXiv preprint arXiv:2102.04306, 2021.

[12]. Kwak S, Hong S, Han B. Weakly supervised semantic segmentation using superpixel pooling network[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2017, 31(1).

[13]. Cao H, Wang Y, Chen J, et al. Swin-Unet: Unet-like Pure Transformer for Medical Image Segmentation[J]. arXiv preprint arXiv:2105.05537, 2021.

- 分享

- 举报

暂无数据

暂无数据-

浏览量:8065次2021-07-19 17:10:27

-

浏览量:9685次2021-07-19 17:09:44

-

浏览量:7113次2021-06-07 09:26:53

-

浏览量:15001次2021-07-05 09:47:30

-

浏览量:157次2023-08-30 15:28:02

-

浏览量:13699次2021-05-11 15:08:10

-

浏览量:9910次2021-06-21 11:49:58

-

浏览量:17232次2021-07-29 10:22:10

-

浏览量:7438次2021-05-04 20:17:10

-

浏览量:15168次2021-05-04 20:16:03

-

浏览量:17058次2021-04-28 16:21:52

-

浏览量:17498次2021-05-31 17:01:00

-

浏览量:7715次2021-04-29 12:46:50

-

浏览量:7369次2021-04-08 11:11:30

-

浏览量:11829次2021-06-25 15:00:55

-

浏览量:1995次2023-02-14 14:48:11

-

浏览量:35137次2021-05-04 20:18:49

-

浏览量:14683次2021-07-08 09:43:47

-

浏览量:104次2023-08-30 20:18:28

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

这把我C

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友